엔비디아가 미국 산호세에서 열린 GTC 2024 기조 연설에서 최대 1조 개 파라미터 모델을 훈련할 수 있는 블랙웰 B200 GPU를 공개했습니다.

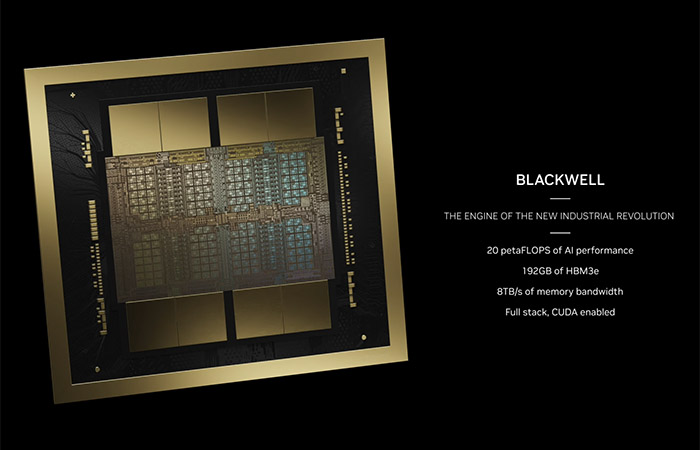

TSMC 4나노미터 공정으로 양산되는 블랙웰 B200은 2080억 개의 트랜지스터를 집적한 GPU로 종전 H100보다 2.5배 더 많은 트랜지스터를 탑재했습니다.

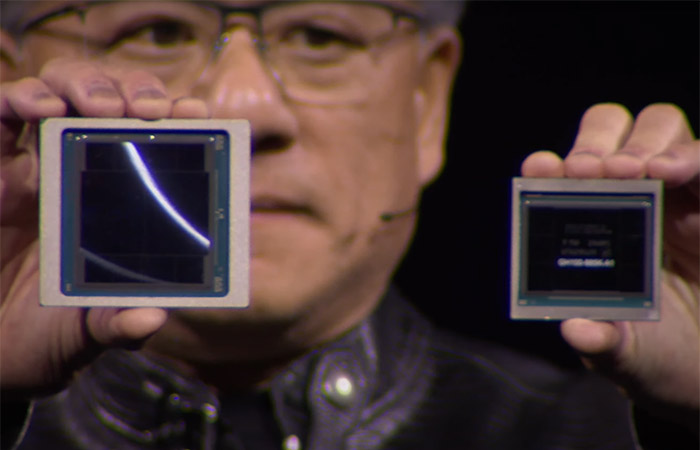

더불어 블랙웰 B200은 4nm 리소그래피 장비의 레티클 크기 제한으로 인해 하나의 다이가 아니라 두 개의 GPU 다이를 NV-HBI로 묶어 칩렛화 했습니다.

NV-HBI(NV-High Bandwidth Interface)는 초당 10TB의 대역폭을 제공하는 데 다이가 각 방향으로 동시에 초당 5TB를 전송하는 것으로 보입니다.

블랙웰 B200은 각 다이가 4개의 HBM3E 메모리 스택과 짝을 이루어 총 8개의 스택으로 구성돼 스택당 앞서 나온 H200처럼 24GB씩 192GB를 갖게 됩니다.

8192비트의 유효 메모리 버스 폭을 가진 B200의 HBM 메모리 대역폭은 초당 8TB이고 스택당 초당 1TB(핀당 8Gbps)의 데이터 속도를 제공합니다.

엔비디아는 이러한 제원의 블랙웰 B200이 H100에 비해 훈련 성능은 4배, 추론 성능은 훨씬 더 큰 30배 향상을 목표로 한다고 밝혔습니다.

특히 챗GPT 같은 트랜스포머 모델을 위한 트랜스포머 엔진의 추론 성능을 강화하기 위해 저정밀도 데이터 유형인 FP4를 지원함으로써 적은 메모리에서 처리량을 높이려 했습니다.

다만 엔비디아는 훈련을 위한 FP64 및 F32 텐서 성능에 대해선 이전 발표와 달리 성능 데이터를 공개하지 않고 있어 이번 B200의 방향성을 궁금하게 만들고 있습니다.