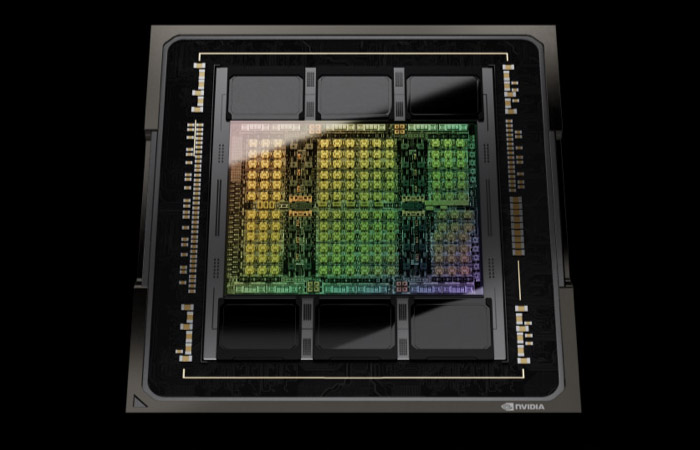

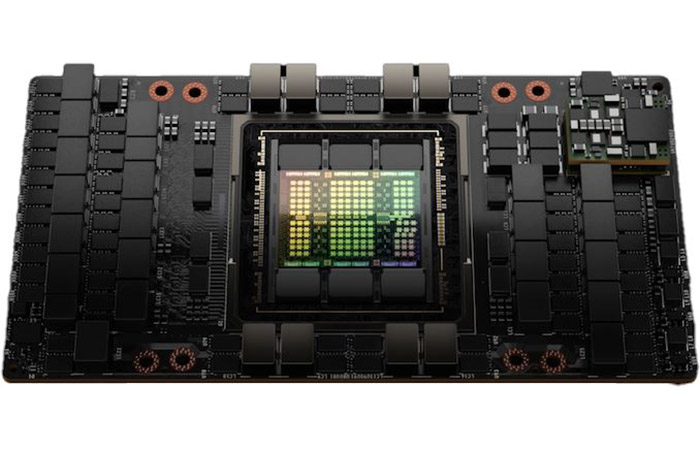

호퍼 아키텍처 기반 H100 다이

엔비디아가 3월 23일 자정(한국 시간 기준)에 진행한 GTC 2022 키노트에서 호퍼 아키텍처 기반 첫 H100 GPU를 공개했습니다.

H100 프로세서는 기계 학습 및 추론을 위해 개발된 고성능 GPU로 서버 및 데이터 센터 등 엔터프라이즈용 제품입니다.

호퍼 아키텍처는 트랜스포머 머신 러닝을 가속할 수 있도록 전문화된 텐서 코어인 트랜스포머 엔진을 설계해 도입한 것이 특징입니다.

H100의 트랜스포머 엔진은 데이터를 두 배 빠르게 압축 및 처리하는 FP8을 엔비디아 기반 휴리스틱을 활용, 레이어별로 FP16과 교환하는 것입니다.

호퍼 아키텍처 기반 H100은 2년 전 암페어 아키텍처 기반의 A100보다 메모리 및 I/O 대역폭을 개선하는 한편 전체 성능을 크게 끌어 올렸습니다.

특히 종전 A100보다 좀더 작아진 다이 크기(814mm2)에도 불구하고 TSMC 4nm 공정으로 양산되면서 800억 개의 트랜지스터(A100은 542억 개)를 집적했습니다.

FP32 쿠다 코어가 16,896개로 A100의 6,912개보다 크게 증가했고, 텐서 코어 역시 528개로 종전 432개보다 증가했습니다.

그래픽 램은 80GB로 유지되나 초당 4.8Gb를 전송하는 HBM3를 도입해 메모리 대역폭은 초당 3TB로 증가했습니다.

각 H100 GPU 유닛은 초당 900GB의 대역폭을 가진 NV링크4로 상호 연결되고, H100은 SXM 폼팩터 또는 PCIe 폼팩터로 제공됩니다.

엔비디아는 이날 H100 기반의 DGX 및 DGX 슈퍼포드, HGX 베이스 보드, PCIe 보드 등을 선보였고, 2022년 3분기에 제품을 출시할 예정입니다.